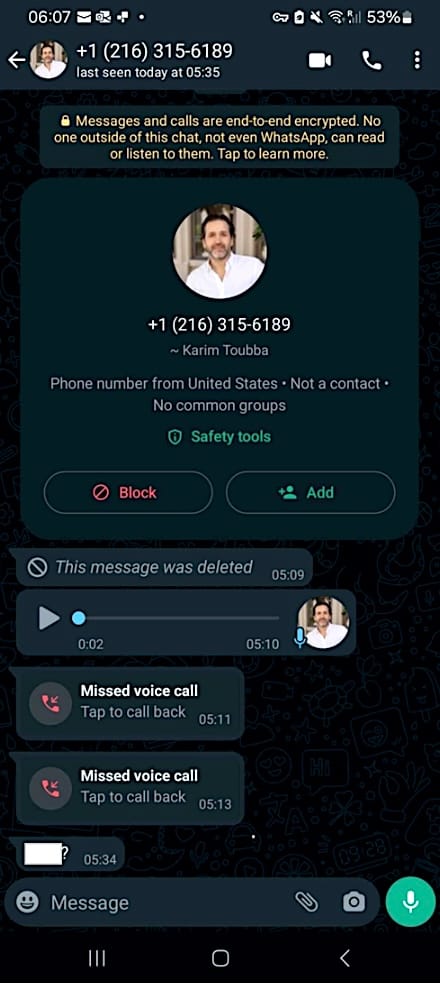

LastPass tiết lộ trong tuần này rằng các đối tượng tấn công đã nhắm vào một trong những nhân viên của họ trong một cuộc tấn công giả mạo bằng giọng nói, sử dụng âm thanh deepfake để mạo danh Karim Toubba, Giám đốc điều hành (CEO) của công ty.

Theo một nghiên cứu toàn cầu gần đây, trong khi 25% mọi người đã từng nhận được cuộc lừa đảo mạo danh giọng nói AI hoặc biết ai đó đã từng gặp phải lừa đảo như vậy, nhân viên LastPass đã không mắc bẫy vì kẻ tấn công sử dụng WhatsApp, một kênh giao tiếp rất bất thường.

"Trong trường hợp của chúng tôi, một nhân viên đã nhận được một loạt các cuộc gọi, tin nhắn văn bản và ít nhất một thư thoại có âm thanh deepfake từ kẻ tấn công mạo danh Giám đốc điều hành của chúng tôi qua WhatsApp", người phân tích số liệu của LastPass Mike Kosak cho biết.

"Vì việc giao tiếp diễn ra khác các kênh giao tiếp kinh doanh thông thường và do nhân viên nghi ngờ về sự hiện diện của nhiều dấu hiệu của tấn công phi kỹ thuật (chẳng hạn như hối thúc liên tục), nhân viên của chúng tôi đã đúng khi phớt lờ các tin nhắn và báo cáo sự việc cho nhóm an ninh nội bộ của chúng tôi để chúng tôi có thể thực hiện các bước để giảm thiểu mối đe dọa và nâng cao nhận thức về chiến thuật này cả bên trong và bên ngoài."

Kosak nói thêm rằng cuộc tấn công đã thất bại và không ảnh hưởng gì đến LastPass. Tuy nhiên, công ty vẫn quyết định chia sẻ chi tiết về sự cố để cảnh báo các công ty khác rằng deepfake do AI tạo ra đã được sử dụng trong các chiến dịch gian lận mạo danh lãnh đạo.

Âm thanh deepfake được sử dụng trong cuộc tấn công này có khả năng được tạo ra bằng cách sử dụng các mô hình âm thanh deepfake được đào tạo trên các bản ghi âm có sẵn của Giám đốc điều hành LastPass, có thể là bản ghi âm này có sẵn trên YouTube.

Điều này xảy ra sau hai lỗ hổng bảo mật được LastPass tiết lộ vào tháng 8 năm 2022 và tháng 11 năm 2022.

LastPass cho biết nền tảng quản lý mật khẩu của họ hiện đang được hàng triệu người dùng và hơn 100.000 doanh nghiệp trên toàn thế giới sử dụng.

Các cuộc tấn công deepfake gia tăng

Cảnh báo của LastPass diễn ra sau cảnh báo của Bộ Y tế và Dịch vụ Nhân sinh Hoa Kỳ (HHS) được ban hành vào tuần trước liên quan đến tội phạm mạng nhắm vào phòng hỗ trợ CNTT sử dụng chiến thuật tấn công phi kỹ thuật và công cụ nhân bản giọng nói AI để đánh lừa mục tiêu của họ.

Việc sử dụng âm thanh deepfake cũng cho phép kẻ tấn công khiến việc xác minh danh tính của người gọi từ xa trở nên khó khăn hơn nhiều, khiến các cuộc tấn công mạo danh giám đốc điều hành và nhân viên công ty rất khó phát hiện.

Mặc dù HHS đã chia sẻ lời khuyên cụ thể cho các cuộc tấn công nhắm vào phòng hỗ trợ CNTT của các tổ chức trong lĩnh vực y tế, những điều sau đây cũng rất hữu ích để tránh các gian lận mạo danh Giám đốc điều hành:

- Yêu cầu gọi lại để xác minh nhân viên yêu cầu đặt lại mật khẩu và thiết bị MFA mới.

- Theo dõi các thay đổi ACH đáng ngờ.

- Xác nhận lại tất cả người dùng có quyền truy cập vào các trang web của người trả tiền.

- Xem xét việc yêu cầu gặp trực tiếp đối với các vấn đề có độ bảo mật cao.

- Yêu cầu giám sát viên xác minh các yêu cầu.

- Đào tạo nhân viên phòng hỗ trợ CNTT để xác định và báo cáo các cách thức tấn công phi kỹ thuật và xác minh danh tính người gọi.

Vào tháng 3 năm 2021, FBI cũng đã ban hành Thông báo cho Ngành tư nhân (PIN) cảnh báo rằng deepfake - bao gồm âm thanh, văn bản, hình ảnh hoặc video được tạo hoặc chỉnh sửa bằng AI - đang trở nên ngày càng tinh vi và có khả năng được sử dụng rộng rãi bởi tin tặc trong "hoạt động an ninh mạng và gây ảnh hưởng nước ngoài".

Ngoài ra, Europol đã cảnh báo vào tháng 4 năm 2022 rằng deepfake có thể sớm trở thành một công cụ mà các nhóm tội phạm mạng thường xuyên sử dụng trong gian lận CEO, can thiệp bằng chứng và tạo nội dung khiêu dâm không được đồng ý.

Theo BleepingComputer.